- Kommentare

- Digitalisierung

Die Macht der Algorithmen

Wenn Computersysteme Menschen beurteilen - wie an einem Berliner Bahnhof -, dann wird es gefährlich, meint Enno Park

»Algorithmus« ist das Gruselwort der vergangenen Jahre. Kaum jemand weiß, was genau das eigentlich ist - jedenfalls wenn es nach einer repräsentativen Umfrage der Bertelsmann-Stiftung im Frühjahr 2018 geht. Dort gaben fast drei Viertel der Befragten an, schon einmal den Begriff Algorithmus gehört zu haben, aber nur etwa zehn Prozent konnten erklären, was das ist. Für die anderen 90 Prozent muss die Welt eine gruselige sein, schließlich entscheiden diese ominösen Algorithmen über Kreditwürdigkeit, Partnerwahl und Polizeieinsätze.

Dabei ist ein Algorithmus einfach nur eine Rechenanweisung. Ein Problem soll in mehreren vorher festgelegten Einzelschritten gelöst werden. Algorithmen haben deshalb zunächst nichts mit Computern zu tun: Wenn wir in der Grundschule schriftliches Dividieren lernen, folgen wir genauso einem Algorithmus wie beim Kochen nach Rezept. Juristen, die Sachverhalte anhand von Paragrafen schematisch prüfen, gehen nach einem komplexen Algorithmus vor. Dasselbe tun Beamte, die über Anträge entscheiden, oder Buchhalter, die Bilanzen aufstellen.

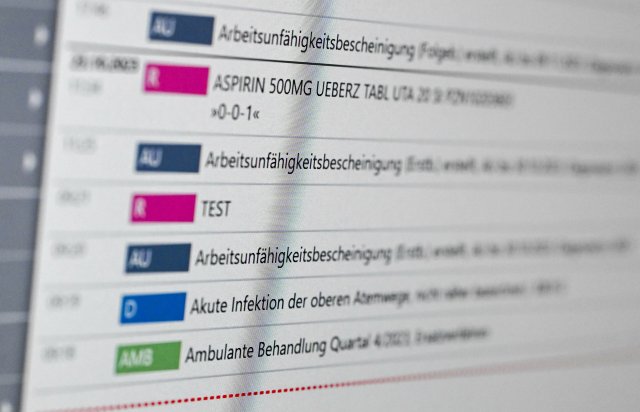

Neu ist noch nicht einmal, dass der Computer die Berechnung von Algorithmen übernimmt. Genau dafür werden Computer seit vielen Jahrzehnten auf allen möglichen Ebenen eingesetzt. Neu hingegen ist künstliche Intelligenz - ein weiterer Begriff, der außerhalb der Informatik leicht missverstanden wird. Schließlich suggeriert er, dass der Computer so ähnlich intelligent sei wie ein Mensch und dann auch so ähnlich agiert. Davon sind aktuelle Computersysteme trotz aller Fortschritte weit entfernt. Deshalb sprechen Fachleute auch lieber von Machine Learning. Der Computer simuliert bestimmte Eigenschaften des Gehirns und kann auf diese Weise tatsächlich lernen.

Allerdings hat dieses Lernen nichts mit menschlichem Denken zu tun. Das zeigt ein einfaches Beispiel: Begegnet ein Kleinkind einem Hund, reicht diese eine Begegnung, und es wird in Zukunft alle anderen Hunde sicher erkennen. Machine-Learning-Systeme können das nicht. Sie müssen mühsam mit Tausenden oder Millionen von Hundebildern trainiert werden, bevor sie einigermaßen sicher in der Lage sind, einen Hund auf einem Bild zu erkennen.

Der Haken beim Machine Learning: Die Programmierer wissen hinterher selber nicht, wie das Computerprogramm eigentlich im Detail entscheidet, ob es sich um einen Hund handelt. Wenn ein Algorithmus, der zu kompliziert ist, um noch von Menschen verstanden werden zu können, Alltagsentscheidungen übernimmt, scheinen wir Menschen die Kontrolle abgegeben zu haben.

Das ist harmlos, wenn es ums Einblenden von Onlinewerbung geht, und praktisch, wenn wir die schnellste Route zu einem Ort wissen möchten. Selbst die Kreditvergabe per Algorithmus hat durchaus ihren Sinn, schließlich ist es im Interesse aller, wenn Banken ihre Risiken minimieren. Gefährlich wird es, wenn die Entscheidungen solcher Systeme Konsequenzen für die algorithmisch beurteilten Menschen haben.

So soll ab September 2018 am Berliner Bahnhof Südkreuz ein Überwachungssystem getestet werden, das Menschen mit auffälligem Verhalten erkennen soll, um sie aus dem Verkehr zu ziehen, bevor sie Straftaten begehen. In einigen Staaten der USA ist es heute schon üblich, dass Computer Prognosen über die Resozialisierung von Straftätern berechnen, anhand derer die Richter dann über Strafmaß und Bewährung entscheiden - bei denen Farbige dann regelmäßig schlechter abschneiden. Und China ist dabei, die gesamte Bevölkerung einem Punktesystem zu unterwerfen. Wer sich im Sinne des Algorithmus mustergültig verhält, bekommt Kredite, Wohnungen und darf vielleicht sogar zwecks Urlaub das Land verlassen.

Doch dass wir damit Macht an Computersysteme abgeben, ist ein weiterer Trugschluss. Denn die Macht wandert nicht vom Menschen zur Maschine, sondern bleibt bei denjenigen Personen, Firmen und Organisationen, die solche Systeme für ihre Zwecke einsetzen. Sie geben keine Macht ab, sondern Verantwortung. In Zukunft können sie sich dahinter verstecken, dass sie auch nicht so genau wissen, wie das Machine-Learning-System zu einem bestimmten Ergebnis kommt: »Entschuldigung, wir wissen auch nicht, warum wir Sie jetzt festnehmen müssen, aber das steht so im Computer. Wahrscheinlich ist es Ihre Schuld.« Am Ende ist einmal mehr nicht die Technik gefährlich, sondern der Mensch, der sie verantwortungslos einsetzt.

Das »nd« bleibt. Dank Ihnen.

Die nd.Genossenschaft gehört unseren Leser*innen und Autor*innen. Mit der Genossenschaft garantieren wir die Unabhängigkeit unserer Redaktion und versuchen, allen unsere Texte zugänglich zu machen – auch wenn sie kein Geld haben, unsere Arbeit mitzufinanzieren.

Wir haben aus Überzeugung keine harte Paywall auf der Website. Das heißt aber auch, dass wir alle, die einen Beitrag leisten können, immer wieder darum bitten müssen, unseren Journalismus von links mitzufinanzieren. Das kostet Nerven, und zwar nicht nur unseren Leser*innen, auch unseren Autor*innen wird das ab und zu zu viel.

Dennoch: Nur zusammen können wir linke Standpunkte verteidigen!

Mit Ihrer Unterstützung können wir weiterhin:

→ Unabhängige und kritische Berichterstattung bieten.

→ Themen abdecken, die anderswo übersehen werden.

→ Eine Plattform für vielfältige und marginalisierte Stimmen schaffen.

→ Gegen Falschinformationen und Hassrede anschreiben.

→ Gesellschaftliche Debatten von links begleiten und vertiefen.

Seien Sie ein Teil der solidarischen Finanzierung und unterstützen Sie das »nd« mit einem Beitrag Ihrer Wahl. Gemeinsam können wir eine Medienlandschaft schaffen, die unabhängig, kritisch und zugänglich für alle ist.