- Kultur

- Facebook und Antifaschismus

Hinsehen und Wegschauen

Probleme mit Facebook: Warum werden antifaschistische Posts gesperrt?

Facebook steht immer wieder im Mittelpunkt von Skandalen. Vor wenigen Monaten erst erhob Frances Haugen, ehemalige leitende Produktmanagerin im Team Civic Misinformation, schwere Anschuldigungen gegen Facebook und belegte diese mit internen Dokumenten. Das Team, dem sie vorstand, sollte eigentlich Falschinformationen und Hetze auf Facebook entgegentreten, doch Haugen kam schnell zu dem Schluss, dass diese Aufgabe nicht zu bewältigen sei und dies von der Leitung auch nicht erwünscht sei. Denn Hass, Lügen und Provokationen erzeugen Erregung und damit mehr Klicks und mehr Interaktion - und die ist die Grundlage des Geschäfts.

Haugen hatte den Eindruck gewonnen, man sei bei Facebook nicht daran interessiert, Falschinformationen und Hetze entgegenzutreten, erklärte sie gegenüber US-amerikanischen Medien und sagte dies auch bei einer Anhörung vor dem US-Kongress am 5. Oktober 2021 aus. Die Ergebnisse eigener interner Untersuchungen zu negativen Auswirkungen auf Kinder und Jugendliche oder zu Falschinformationen, Gewaltaufrufen, Hasspostings usw. seien von der Unternehmensleitung ignoriert und vertuscht worden. Ganz zu schweigen von externen wissenschaftlichen Untersuchungen.

Es sei für Facebook und seinen Algorithmus »einfacher, Menschen zu Wut zu inspirieren als zu anderen Emotionen«, sagte Haugen in der CBS-Sendung »60 Minutes«. Gegenüber Jan Böhmermann erklärte sie auf dem Youtube-Kanal von »ZDF-Magazin Royale«: »Man kennt die Probleme, die diese Produkte schaffen, und tut einfach nichts dagegen. Nur weil man auch auf die kleinsten Profite nicht verzichten möchte.«

Anhand meiner persönlichen Erfahrungen mit Facebook kann ich diese Kritik nur bestätigen. Die Aussagen der Whistleblowerin sowie die wissenschaftlichen Untersuchungen zum Zusammenhang zwischen den (bewussten oder unbewussten) Vorurteilen von Programmierern und den Entscheidungen der Algorithmen, nähren den Verdacht, Facebook könnte eine Tendenz haben, diskriminierende Inhalte zu ignorieren oder gar hervorzuheben. Ich habe auf Facebook eine lange Geschichte von sich wiederholenden Sperrungen. Diese betreffen nahezu ausschließlich antifaschistische Postings. Nur in einem Fall wurde ich wegen eines Kommentars in einer sprachwissenschaftlichen Debatte gesperrt. Dabei ging es um die zahlreichen möglichen Verwendungen eines Wortes bzw. Wortstamms im venezolanischen Spanisch. Ich legte die Möglichkeit dar, den Begriff als »Schlag« zu verwenden, im Sinne von »Ich hau die eine rein …« - und schon wurde ich gesperrt.

Meine letzte Sieben-Tage-Sperrung nach Postings oder Kommentaren erfolgte, weil ich auf der Facebook-Seite eines Bekannten in Brasilien postete, dass Reinhard Gehlen, der Gründer des westdeutschen Geheimdienstes BND nach dem Zweiten Weltkrieg, ein Nazi war und meinen Kommentar mit einem Foto von Gehlen aus Wikipedia ergänzte. Der von mir kommentierte Post meines Bekannten handelte davon, welche Nazis nach dem Zweiten Weltkrieg in Deutschland, Österreich, in europäischen Institutionen und der Nato Karriere gemacht hatten. Gegenüber Facebook konnte ich meiner Sperrung widersprechen. Dem Widerspruch wurde stattgegeben, doch 15 Minuten später wurde ich wegen desselben Postings ohne Widerspruchsmöglichkeit wiederum gesperrt. Ich durfte eine Woche lang nichts posten oder kommentieren und durfte 90 Tage lang nicht mit Beiträgen live gehen und keine Werbung schalten (was mich weniger stört).

2021 wurde ich mehrmals gesperrt. Am 30. April, weil ich an diesem Tag, an dem Adolf Hitler 1945 im sogenannten Führerbunker in Berlin Selbstmord beging, ein allseits bekanntes Stencil (eine Schablone für Graffiti) mit dem stilisierten Bild von Hitlers Selbstmord und dem Slogan »Follow your leader« (Folge dem Führer) gepostet hatte. Kurze Zeit später entdeckte der Facebook-Algorithmus mein Posting zum Jahrestag der (Selbst-)Befreiung vom Faschismus in Italien am 25. April 1945: Ein bekanntes Foto, auf dem die Leichen von Mussolini und weiteren faschistischen Führern zu sehen sind, die von Partisanen exekutiert worden waren und dann mit dem Kopf nach unten auf dem Mailänder Piazzale Loreto in einer Reihe aufgehängt wurden. In Italien ist dieses Bild zum Jahrestag immer wieder in Medien zu finden. Offensichtlich aber war ich nicht der Einzige, der wegen dieses Fotos gesperrt wurde.

Dann fand ich ein Meme, auf dem der Kopf von Mussolini dreimal richtig und einmal falsch herum abgebildet war. Unter den ersten drei Köpfen stand »Facebook, Instagram und Twitter«, unter dem vierten stand »Piazzale Loreto«. Daraufhin wurde ich erneut gesperrt. Weitere Sperren erfolgten, weil Facebook herausfand, dass ich das bekannte Foto vom Piazzale Loreto auch in den Vorjahren gepostet hatte. Stets wurde mir als Begründung mitgeteilt, ich hätte gegen die »Gemeinschaftsstandards« verstoßen. Widerspruch konnte ich nur ausnahmsweise einlegen, und wenn ich es tat, blieb er erfolglos. Das sollte nicht weiter verwundern: Auch bei autoritären Regimen ist Widerspruch nicht erwünscht.

Diese Erfahrungen nahm ich zum Anlass, eine eigene kleine empirische Untersuchung durchzuführen. In den Folgemonaten meldete ich Facebook insgesamt rund 400 rassistische, antisemitische, islamfeindliche, frauenfeindliche und faschistische Beiträge (Postings und Kommentare) auf Deutsch, Englisch, Spanisch und Italienisch. Eine Löschung der von mir gemeldeten Beiträge erfolgte in weniger als zehn Fällen, obwohl zahlreiche Postings in Deutschland und Italien auch strafrechtlich relevant waren.

Zu den diversen Postings, die für Facebook anscheinend nicht gegen die »Gemeinschaftsstandards« verstießen, gehörten der Aufruf oder die Forderung, Flüchtlinge zu erschießen oder zu ertränken; Frauen, Homosexuelle und Menschen mit nichtweißer Hautfarbe als minderwertig zu bezeichnen bzw. Letztere mit »Abschaum« oder »Ungeziefer« zu vergleichen. Auch Forderungen, Lesben zu vergewaltigen, verstoßen nicht gegen die »Gemeinschaftsstandards«. Obwohl die Kommentare auf den Facebook-Seiten italienischer Medien besonders aggressiv waren, wurden sie weder von diesen Medien (hauptsächlich die Tageszeitung »La Repubblica«) gelöscht noch von Facebook gesperrt. Zwei herausragende Beispiele aus Deutschland, die nicht gesperrt wurden: Das Feiern des Geburtstags eines »gewissen Adolf« am 20. April sowie der Post, dass Probleme bei der Leichenverbrennung in Dresden zum Höhepunkt der Covid-Pandemie ein Indiz dafür wären, die Existenz der Vernichtungslager der Nazis bezweifeln zu können.

Es wird deutlich, dass die Praxis von Facebook über ein simples Übersehen oder Zulassen von Falschmeldungen und Hass hinausgeht. Die Algorithmen, die Künstliche Intelligenz (KI) und die zuständigen Mitarbeiter*innen tolerieren die meisten solcher Postings und ignorieren die Kritik daran.

Entgegen der gängigen Meinung, KI und die aufgestellten Algorithmen seien neutral, ist festzuhalten: Künstliche Intelligenz wird von Menschen programmiert. Und diese Menschen sind mehrheitlich weiß, männlich, heterosexuell und im Globalen Norden angesiedelt. Ihre Vorurteile werden perpetuiert.

Wissenschaftliche Untersuchungen von Software zur Bewertung von Bewerbungen zeigen, dass die KI Menschen mit dunkler Hautfarbe oder mit Kopftuch grundsätzlich schlechter bewertet als Menschen mit weißer Hautfarbe. Das gilt auch für online durchgeführte Schönheitswettbewerbe. Gesichtserkennungsprogramme erkennen dunkle Gesichter schlechter als weiße, bei Sicherheits- und Überwachungssoftware gelten sie als suspekter. Es ist naheliegend, davon auszugehen, dass der politische Bias zahlreicher Programmierer*innen in die KI eingeht.

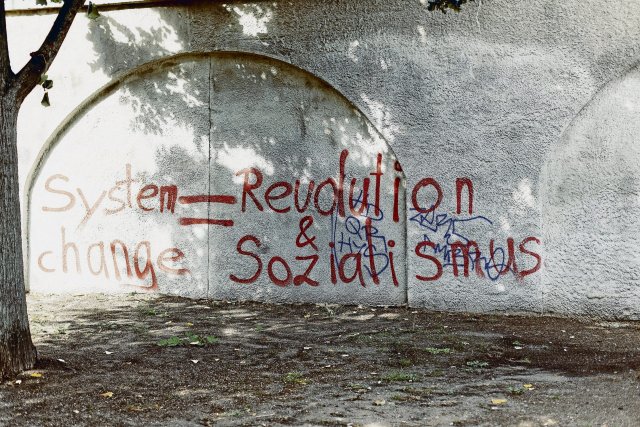

Anders gesagt: Kapital, Bürgertum und Kleinbürgertum bewerten linke, sozialistische und kommunistische Ansichten und Aktivitäten stets als bedrohlicher als rechte und rechtsextreme Ansichten und Aktivitäten. Warum sollte also die KI anders agieren? Und ob nun bei Facebook die Mitarbeiter*innen, die offiziell die Meldungen der User überprüfen, solche Ansichten tendenziell teilen oder so überarbeitet und überfordert sind, dass sie der KI recht geben, sei dahingestellt. Am Ergebnis ändert es nichts.

Das »nd« bleibt. Dank Ihnen.

Die nd.Genossenschaft gehört unseren Leser*innen und Autor*innen. Mit der Genossenschaft garantieren wir die Unabhängigkeit unserer Redaktion und versuchen, allen unsere Texte zugänglich zu machen – auch wenn sie kein Geld haben, unsere Arbeit mitzufinanzieren.

Wir haben aus Überzeugung keine harte Paywall auf der Website. Das heißt aber auch, dass wir alle, die einen Beitrag leisten können, immer wieder darum bitten müssen, unseren Journalismus von links mitzufinanzieren. Das kostet Nerven, und zwar nicht nur unseren Leser*innen, auch unseren Autor*innen wird das ab und zu zu viel.

Dennoch: Nur zusammen können wir linke Standpunkte verteidigen!

Mit Ihrer Unterstützung können wir weiterhin:

→ Unabhängige und kritische Berichterstattung bieten.

→ Themen abdecken, die anderswo übersehen werden.

→ Eine Plattform für vielfältige und marginalisierte Stimmen schaffen.

→ Gegen Falschinformationen und Hassrede anschreiben.

→ Gesellschaftliche Debatten von links begleiten und vertiefen.

Seien Sie ein Teil der solidarischen Finanzierung und unterstützen Sie das »nd« mit einem Beitrag Ihrer Wahl. Gemeinsam können wir eine Medienlandschaft schaffen, die unabhängig, kritisch und zugänglich für alle ist.