- Wissen

- Künstliche Intelligenz

Technisch optimierter Rassismus

Wie eine intersektionale, Schwarzfeministische Perspektive Diskriminierung durch Künstliche Intelligenz erkennen und kritisieren kann

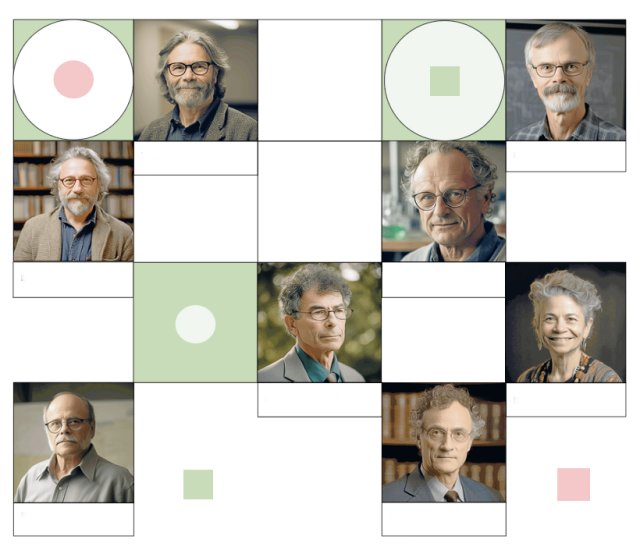

Mit der in kurzer Zeit rasant gestiegenen Nutzung von ChatGPT und der Leistungsfähigkeit von sogenannten Large Language Models (LLMs) gab es Anfang 2023 einen Aufschrei in der Wirtschafts- und Technikelite. Ungewöhnlich deutlich haben führende Expert*innen vor den Risiken Künstlicher Intelligenz (KI) gewarnt. Prominente Beispiele sind der Nobelpreisträger für Wirtschaftswissenschaften Joseph E. Stiglitz und der Informatiker Geoffrey Hinton, einer der Mitbegründer der KI-Forschung. Während Stiglitz sich um die wirtschaftlichen Folgen von KI sowie wachsende Ungleichheit sorgt, warnt Hinton vor der Kontrolle von KI über die Menschheit.

Bereits im Jahr 2021 hatte die KI-Ethikerin Timnit Gebru zusammen mit Kolleg*innen in einem wissenschaftlichen Artikel auf die Gefahren von LLMs aufmerksam gemacht. Gebru, eine Schwarze Frau mit Wurzeln in Äthiopien, die bei Google eine Führungsrolle im Bereich Ethik innehatte, wurde im Zusammenhang mit diesem Artikel entlassen. Kritiker*innen von Google und der Entscheidung, ihr zu kündigen, weisen darin eine diskriminierende Praxis nach. Die Wissenschaftlerinnen Katlyn Turner, Danielle Wood und Catherine D’Ignazio sprechen in einem Artikel von einem frauenfeindlichen und rassistischen Playbook, also einer typischen Vorgehensweise im Hinblick auf den Umgang mit Schwarzen Frauen und anderen marginalisierten Geschlechtern, die sich mit Ungerechtigkeit in der Technikbranche befassen. Schwarze Frauen in der Technikbranche forschen nicht nur zu Diskriminierung durch Technik (wie Bias und die Unterdrückung marginalisierter Gruppen durch KI), sie sind auch selbst von Diskriminierung betroffen.

Mit unserem wöchentlichen Newsletter nd.DieWoche schauen Sie auf die wichtigsten Themen der Woche und lesen die Highlights unserer Samstagsausgabe bereits am Freitag. Hier das kostenlose Abo holen.

Im Folgenden wird anhand des Beispiels von Rassismus gezeigt, wie gesellschaftliche Diskriminierungsmuster durch Algorithmen abgebildet und verstärkt werden. Schwarze Menschen werden beispielsweise durch die KI-gestützte Vermittlung von Inhalten in den sozialen Medien und im Internet marginalisiert. Im Zusammenhang mit Hassrede in den sozialen Netzwerken werden die Stimmen Schwarzer Menschen unterdrückt. Hierbei ist wichtig, eine strukturelle Perspektive auf Diskriminierung einzunehmen. Der amerikanische Schwarze Feminismus bietet solch eine Perspektive und spricht nicht nur von strukturellem Rassismus in den USA, sondern auch von struktureller Diskriminierung durch KI. Was steckt dahinter?

Rassismus in der Gesellschaft

Eine häufig zitierte Definition von Rassismus stammt von der Geografin Ruth Gilmore, die darunter eine künstliche Differenzierung zwischen Gruppen und das Ausnutzen von sozial konstruierten Unterschieden zur Bevorteilung einer Gruppe und Unterdrückung anderer Gruppen versteht. Kritische Theorien setzen sich intensiv mit Ideen von »Rasse« und den Dynamiken von Rassismus auseinander. Dies kann auf die lange Geschichte des Rassismus in den USA zurückgeführt werden, zum Beispiel die Sklaverei und die Jim-Crow-Segregation.

Als offene Form des Rassismus zählen rechtsextremistische Übergriffe auf Menschen mit Migrationshintergrund beziehungsweise Menschen mit dunkler Hautfarbe. Subtilere Formen des Rassismus sind Alltagsdiskriminierungen wie Mikroaggressionen. Während Alltagsrassismus häufig keine unmittelbaren körperlichen Folgen hat, sind die psychischen Folgen nicht zu unterschätzen.

Eine besonders hartnäckige Form des Rassismus ist der strukturelle Rassismus. Hier handelt es sich um ein Zusammenspiel von institutionellen Strukturen, Verhaltensweisen und sozialisierten Denkweisen, die von allen Menschen verinnerlicht werden (etwa durch verzerrte Geschichtsschreibung in Schulbüchern oder die Darstellung von Stereotypen in Filmen). Für weiße Menschen bedeutet struktureller Rassismus eine unsichtbare Bevorteilung (genannt White Privilege), während Schwarze sozial ausgeschlossen werden und schlechtere Chancen auf sozialen Aufstieg haben.

Neben offenem und subtilem Rassismus wird auch zwischen biologischem und kulturellem Rassismus unterschieden. Der biologische Rassismus sieht den weißen Menschen dem Schwarzen Menschen aufgrund genetischer Faktoren überlegen. In Europa herrscht gegenwärtig ein kultureller Rassismus vor, der sich in der Diskriminierung von religiösen oder ethnischen Gruppen äußert und vor allem in Diskussionen um eine Leitkultur zum Vorschein tritt. In Europa sind insbesondere muslimische Menschen vom kulturellen Rassismus betroffen.

Schwarzfeministisch KI beforschen

Der US-amerikanische Schwarze Feminismus ist eine kritische soziale Theorie und Bewegung, die Wissenschaft und Aktivismus miteinander verbindet, um ungleiche Machtbeziehungen in der Gesellschaft zu verstehen und infrage zu stellen. Entwickelt von Schwarzen Frauen und anderen marginalisierten Geschlechtern im Zuge ihrer Erfahrungen der Unterdrückung während der Sklaverei in den USA, ist der Schwarze Feminismus eine Theorie situierten Wissens. Das bedeutet, dass die Erkenntnisse und Perspektiven der Theorie auf den gelebten Erfahrungen Schwarzer Frauen beruhen. Der Schwarze Feminismus sieht eine untrennbare Verbindung zwischen Unterdrückung und Widerstand: Das heißt, es besteht eine Verbindung zwischen dem Bewusstsein, dass Schwarze Frauen in den USA strukturell benachteiligt oder ausgebeutet werden und dem Verlangen, diese unterdrückerischen Machtverhältnisse zu beenden.

Um gesellschaftliche (und sozio-technische) Machtbeziehungen sichtbar zu machen, betrachten Schwarze Feminist*innen in ihren Analysen sogenannte Machtsysteme. In der amerikanischen Schwarzfeministischen Theorie wird von »Rasse« als Machtsystem gesprochen; in Deutschland werden häufig die Wörter Ethnizität oder Hautfarbe verwendet. Weitere Machtsysteme sind Geschlecht, Sexualität, Klasse (oder sozio-ökonomischer Status) und Behinderung. Diese Machtsysteme sind Konglomerate aus sozial konstruiertem Wissen, Erzählungen und Symbolen, welche die Gestaltung von Institutionen, Politiken und Praktiken prägen. Machtsysteme beruhen auf der sozialen Konstruktion menschlicher Unterschiede. Sie strukturieren Gesellschaft und Technik, indem sie bestimmte Normen etablieren und fördern und solche Menschen und Praktiken ausgrenzen, die nicht der Norm entsprechen.

Machtsysteme existieren allerdings nicht isoliert voneinander. Sie interagieren in ihrer Prägung von sozio-technischen Beziehungen. Bedeutend ist daher auch die intersektionale Perspektive des Schwarzen Feminismus. Intersektionalität bedeutet, dass verschiedene Machtsysteme bei der Diskriminierung von sozialen Gruppen ineinandergreifen. Die Verbindung von rassistischer und sexistischer Diskriminierung heißt für Schwarze Frauen, dass sie nicht nur stärker, sondern in ganz eigener Art und Weise benachteiligt werden. So wird sexuelle Gewalt von weißen und Schwarzen Frauen unterschiedlich erlebt, beispielsweise in Fällen, in denen Schwarze Frauen im Frauenhaus abgewiesen werden oder Migrantinnen keine Unterstützung in ihrer Muttersprache erhalten. Intersektionalität hat auch in der Informatik und im Technikdesign große Popularität gewonnen und wird als Methode verwendet, um die komplexen Erfahrungen von marginalisierten Nutzer*innen zu verstehen und beim Design von Technik einzubeziehen.

Vorteile einer strukturellen Perspektive

Eine strukturelle Perspektive auf Rassismus und KI betrachtet nicht die individuelle Motivation einer Technik-Entwicklerin oder das individuelle Verhalten einer Nutzerin, sondern interessiert sich für das Zusammenspiel von systemischen Faktoren. Eine strukturelle Perspektive betrachtet den Kontext der Technikentwicklung, wie etwa die politischen, kulturellen, sozialen und ökonomischen Rahmenbedingungen. KI ist eingebettet in eine komplexe Struktur von Bedingungen – von der (mangelnden) Regulierung von KI bis zum kommerziellen Interesse der Tech-Unternehmen an personalisierter Werbung –, welche wiederum durch Machtsysteme geprägt sind.

Aus Schwarzfeministischer Sichtweise ist es wichtig zu überlegen, wie Ideen von biologischen »Rassen« oder angeblichen ethnischen und kulturellen Unterschieden zwischen Menschengruppen die Rahmenbedingungen der Gesellschaft und Technikentwicklung prägen. Dies heißt nicht, dass individuelle Einflüsse auf die Technikentwicklung oder persönliche Erfahrungen von Nutzer*innen außer Acht gelassen werden sollten. Eine strukturelle Perspektive kann jedoch besser erwägen, wie Individuen von Strukturen beeinflusst werden und das individuelle Verhalten prägen.

Das Beispiel Rassismus eignet sich zur Veranschaulichung. Rassismus ist nicht nur eine individuelle Einstellung, sondern wird durch die Institutionen gefördert, die auf den Einzelnen einwirken. Rassismus ist nicht nur der rechtsextremistische Übergriff oder deutlich verbalisierter Hass gegenüber Schwarzen Menschen, sondern kann auch subtil und unter dem Deckmantel der Gleichberechtigung existieren. So spiegeln sich insbesondere liberale Formen des Rassismus wie die sogenannte Farbenblindheit in der Technikentwicklung wider. Farbenblindheit ist die Überzeugung, dass die Regierung, Gerichte, Universitäten und Arbeitgeber*innen in Bezug auf die Herkunft und Hautfarbe einer Person neutral sein sollten. Dies steht im Kontrast zu der Auffassung, dass historisch benachteiligte Gruppen bewusst bevorteilt werden sollten (was unter dem Begriff Affirmative Action diskutiert wird). Während Nichtdiskriminierung (Neutralität) in einer Gesellschaft mit geringen Ungleichheiten ein wichtiger Wert ist, wird Nichtdiskriminierung in einer Gesellschaft mit einer rassistischen Vergangenheit zu einer Strategie der Aufrechterhaltung von Ungleichheit. Daher können liberale Haltungen in Form von Farbenblindheit ebenso wie direkte Formen des Rassismus zu ungerechten gesellschaftlichen Beziehungen führen.

Keine neutrale Technik

Liberale Behauptungen über die Neutralität und Inklusivität von Technik wurden insbesondere in der frühen Zeit des Internets geäußert. Es war ein Moment der Begeisterung und Hoffnung, eine digitale Gesellschaft zu verwirklichen, in der Hautfarbe und Geschlecht keine Rolle spielten, solange man Teil des Cyberspace sei. In ähnlicher Weise wird die algorithmische Vermittlung von Entscheidungen (etwa über Anträge zur Gewährung eines Kredits) im Vergleich zu rein menschlichen Entscheidungen als neutral angesehen. Maschinen sollen Menschen dabei unterstützen, neutrale oder »faire« Entscheidungen zu treffen. Die Auffassung, dass Technik neutral sei, verschleiert jedoch problematische Dynamiken, die dafür sorgen, dass Technik vorrangig für weiße Menschen optimiert ist.

So stützt sich die Entwicklung von Algorithmen auf die Verwendung von Daten aus der Vergangenheit. Eine Gesellschaft mit einer Geschichte von Ungerechtigkeit hat im Laufe der Jahrhunderte Daten produziert (Bücher, Malereien, Fotografien, Filme, Statistiken), die diese Ungerechtigkeiten widerspiegeln. Folglich werden Muster der Vergangenheit in der Gegenwart reproduziert. Außerdem wurden das Internet und die weit verbreiteten Plattformen der sozialen Medien im Silicon Valley in den USA entwickelt und sind von weißen, vorrangig männlichen Perspektiven geprägt.

Wenn man die Interaktion zwischen Gesellschaft und Technik in Betracht zieht, dann ist es nicht nur die Aufgabe der Informatiker*innen, Rassismus in Technik zu verhindern, sondern eine gesamtgesellschaftliche Aufgabe. Denn Informatiker*innen arbeiten mit den Informationen, Rahmenbedingungen und Denkweisen, die in der Gesellschaft existieren. Gleichzeitig haben Technikentwickler*innen eine Verantwortung, die bestehenden Strukturen zu hinterfragen und Rassismus nicht zu verstärken. Auch kann man fragen, ob Informatiker*innen nicht ihre Produkte und Dienstleistungen im Sinne einer positiven Diskriminierung für marginalisierte Menschen optimieren sollten.

Fallbeispiel Hassrede

Die Verbreitung von Hassrede in sozialen Plattformen veranschaulicht, dass Rassismus in sozialen Plattformen kein bloßer Ausdruck von individuellem Nutzungsverhalten ist. Stattdessen spielt die algorithmische Vermittlung von Inhalten und die Gestaltung digitaler Dienste eine ebenso wichtige Rolle. Die Tatsache, dass Inhalte wie rassistische Hassrede nicht besser reguliert werden, könnte mit einer Voreingenommenheit der Plattform-Entwickler*innen zu tun haben. Da weiße Nutzer*innen als die Norm im Design gelten, gibt es wenig Bewusstsein für die Erfahrungen Schwarzer Nutzer*innen. Darüber hinaus sorgt die oben genannte These der Technik-Neutralität dafür, dass spezifische Risiken der Online-Interaktion für Schwarze Nutzer*innen in den Hintergrund geraten.

Eine intersektionale Perspektive hilft, misogyne und rassistische Angriffe auf Schwarze Frauen, auch »Misogynoir« genannt, aufzudecken.

-

Wichtig ist ebenso zu erkennen, dass Hassrede in sozialen Plattformen Schwarzen Frauen gegenüber anders gelagert ist als gegenüber Schwarzen Männern. Eine intersektionale Perspektive hilft, misogyne und rassistische Angriffe auf Schwarze Frauen, auch »Misogynoir« genannt, aufzudecken. Die Schwarzfeministische Perspektive geht jedoch weiter. Sie zeigt, dass »einfache« Lösungen wie die automatisierte Löschung von Hassrede ins Verhältnis zu globalen, ungleichen und von Rassismus geprägten Machtbeziehungen gesetzt werden müssen: Ein klassischer Ansatz zur Bekämpfung von Hassrede ist es, Vorfälle zu verfolgen, zu melden und rasch zu entfernen. Dieser Ansatz kann zwar den schlimmsten Schaden verhindern, lässt aber Fragen der Ungleichheit bei der Umsetzung dieser Maßnahmen außer Acht. Die Entfernung von Inhalten auf Online-Plattformen wird teilweise durch eine KI-basierte Software vollzogen, welche problematische Inhalte automatisch erkennt (zum Beispiel über Spracherkennung) und löscht. Diese Software kann jedoch speziell Misogynoir nicht erkennen und weist darüber hinaus rassistischen und geschlechtsspezifischen Bias auf.

So kann die Software fälschlicherweise Posts mit Ausdrücken markieren und entfernen, die als Hassrede gelten, aber von der betroffenen Gruppe in einer politisch ermächtigenden Weise verwendet werden (etwa das N-Wort). Dies kann dazu führen, dass bereits marginalisierte Nutzer*innen durch die automatisierte Entfernung von Inhalten mundtot gemacht werden. Hier zeigt sich, dass der Kontext für die Entfernung von Hassrede in sozialen Plattformen eine wichtige Rolle spielt; Kulturen des Widerstands gegen Rassismus müssen berücksichtigt werden.

Ein weiterer relevanter Aspekt des Entfernens von illegalen Inhalten ist die »Reinigung« der Plattformen. Diese Arbeit des Überprüfens und Entfernens rassistischer Inhalte wird von Niedriglohn-Arbeiter*innen aus prekären Verhältnissen im Globalen Süden getätigt. Schwarze Feminist*innen betrachten in ihren Analysen also nicht nur die Notwendigkeit der Regulierung von rassistischen Inhalten, sondern auch die globale Machtverteilung und die kapitalistisch geprägte digitale Ökonomie. Es wird deutlich, dass es strukturelle Veränderungen in Bezug auf weiße und westlich geprägte Prozesse der Technikentwicklung sowie ein anderes Verhältnis zu Konsum und Profit in der Technikbranche braucht, um strukturellen Rassismus auch strukturell zu bekämpfen.

Auf der Suche nach Lösungen

Auf der Suche nach Lösungen für Rassismus durch KI gibt es unterschiedliche Ansätze. Ein Ansatz in der Informatik ist die nachträgliche Korrektur algorithmischer Entscheidungen durch sogenannte Fairness-Methoden. In der Informatik werden diese technischen Anpassungen eines Computermodells unter dem Stichwort »Machine Learning Fairness« entwickelt und diskutiert. Das Ziel ist es, den Einfluss eines verzerrten Datensatzes im Nachhinein zu korrigieren, sodass die Entscheidung über einen Kredit oder eine Krankheits-Diagnose nicht nur für weiße Menschen funktioniert beziehungsweise diese bevorteilt. Fairness-Methoden nehmen häufig Rückbezug auf Kategorien und Daten von Schwarzen und weißen Menschen sowie Männern und Frauen. Dies hat jedoch Kritik hervorgerufen, weil es sich bei Fairness-Kategorien um sehr vereinfachte Kategorien handelt, die strukturelle, intersektionale Diskriminierung eher verschleiern als adressieren.

Fairness-Methoden sind ein Beispiel für den Trend, KI möglichst diversitätssensibel zu gestalten, also dass innovative Produkte für ein breites Spektrum von Nutzer*innen gewinnbringend sind. Beim diversitätssensiblen Technikdesign werden Diversitäts-Konzepte herangezogen und in ein Computersystem eingeschrieben, durch einerseits eine Definition von Vielfalt, zum Beispiel Vielfalt unter den Nutzer*innen einer App, und andererseits durch eine normative Idee im Zusammenhang mit Diversität wie Toleranz, Inklusion oder Gerechtigkeit. Technik diversitätssensibel zu gestalten ist ein wichtiger Ansatz, um die häufig unbewussten Normen in der Technikentwicklung zu hinterfragen.

Ist der anvisierte Nutzer ein weißer technikaffiner und berufstätiger Mann in der Großstadt? Oder gibt es auch Raum in der Visualisierung von Nutzer*innen für Menschen in sozial prekären Situationen, Menschen mit Migrationshintergrund, Menschen mit einer körperlichen Beeinträchtigung, mit mangelnder Bildung? Diversitätssensibles Technikdesign hat Potenzial, solch eine Diskussion über die Bedeutung von Vielfalt in der Gesellschaft und ihrem Abbild in der KI anzustoßen.

Erfahrungen von marginalisierten Gruppen sollten im Design-Prozess priorisiert werden, um die Technik nicht fairer (also neutral), sondern gerechter zu machen. Ebenso muss klar sein, dass diversitätssensibles Design eine Vielzahl von Diversitäts-Begriffen heranziehen kann. Es ist also nicht gesagt, dass diversitätssensible KI zwangsläufig zu mehr Gerechtigkeit führt. Vielmehr kommt es darauf an, wie Diversität definiert und im Design-Prozess eingebettet wird.

Die oben genannten Maßnahmen sind gute Ansätze, aber nicht ausreichend, um strukturelle Veränderung in der Gesellschaft und Technikentwicklung zu bewirken. Wichtig für die Eindämmung von Rassismus durch KI ist die Bekämpfung von Rassismus in der Gesellschaft. Man muss dort ansetzen, wo gesellschaftliche Verhältnisse produziert werden, etwa über die zuvor beschriebenen Machtsysteme. Die sozial konstruierten Unterschiede zwischen Menschen (etwa in Kategorien von »Rasse«, Ethnizität, Geschlecht, Kultur, Sexualität) dürfen nicht als natürlich oder selbstverständlich akzeptiert werden. Sie wurden in einem bestimmten historischen Kontext mit einer gewissen Motivation entwickelt. Die Denkmuster und daraus resultierende Handlungsweisen der Mehrheitsgesellschaft infrage zu stellen und zu verändern ist daher zentral, um auch strukturellem Rassismus durch KI entgegenzuwirken. Schließlich sind gesellschaftliche Verhältnisse auch sozio-technische Verhältnisse, denn Gesellschaft und Technik beeinflussen sich gegenseitig.

Laura Schelenz ist wissenschaftliche Mitarbeiterin am Internationalen Zentrum für Ethik in den Wissenschaften an der Universität Tübingen.

Der Text ist eine gekürzte Fassung des Beitrags »Rassismus durch Künstliche Intelligenz?« aus dem Sammelband »Code & Vorurteil. Über Künstliche Intelligenz, Rassismus und Antisemitismus«, herausgegeben von Marie-Sophie Adeoso, Eva Berendsen, Leo Fischer und Deborah Schnabel (Verbrecher-Verlag, 232 S., br., 20 €).

Das »nd« bleibt. Dank Ihnen.

Die nd.Genossenschaft gehört unseren Leser*innen und Autor*innen. Mit der Genossenschaft garantieren wir die Unabhängigkeit unserer Redaktion und versuchen, allen unsere Texte zugänglich zu machen – auch wenn sie kein Geld haben, unsere Arbeit mitzufinanzieren.

Wir haben aus Überzeugung keine harte Paywall auf der Website. Das heißt aber auch, dass wir alle, die einen Beitrag leisten können, immer wieder darum bitten müssen, unseren Journalismus von links mitzufinanzieren. Das kostet Nerven, und zwar nicht nur unseren Leser*innen, auch unseren Autor*innen wird das ab und zu zu viel.

Dennoch: Nur zusammen können wir linke Standpunkte verteidigen!

Mit Ihrer Unterstützung können wir weiterhin:

→ Unabhängige und kritische Berichterstattung bieten.

→ Themen abdecken, die anderswo übersehen werden.

→ Eine Plattform für vielfältige und marginalisierte Stimmen schaffen.

→ Gegen Falschinformationen und Hassrede anschreiben.

→ Gesellschaftliche Debatten von links begleiten und vertiefen.

Seien Sie ein Teil der solidarischen Finanzierung und unterstützen Sie das »nd« mit einem Beitrag Ihrer Wahl. Gemeinsam können wir eine Medienlandschaft schaffen, die unabhängig, kritisch und zugänglich für alle ist.